Il y a trois ans, j'ai écrit sur un brevet Google qui analysait la réaction d'un chercheur aux résultats de recherche pour classer ces résultats, dans l'article suivant: Les paramètres biométriques en tant que signal de classement dans les résultats de recherche Google?

Depuis lors, je surveille les dépôts de brevets de Google qui utilisaient un appareil photo pour smartphone pour regarder l'expression d'un utilisateur de cet appareil afin de mieux comprendre les émotions de cette personne.

Une demande de brevet relative à un tel procédé a été déposée. Je me demande si la plupart des gens se sentiraient à l’aise pour utiliser le processus décrit dans ce nouveau dépôt de brevet.

Le résumé de cette nouvelle approche brevetée est l’un des plus brefs que j’ai vu:

«Certains appareils informatiques (téléphones mobiles, tablettes, etc.) fournissent des claviers graphiques, des systèmes de reconnaissance de l'écriture manuscrite, des systèmes de synthèse vocale et d'autres types d'interfaces utilisateur (« UI ») permettant de composer des documents et des messages électroniques. De telles interfaces utilisateur peuvent fournir à un utilisateur des moyens de saisir du texte ainsi que d'autres formes limitées de contenu multimédia (par exemple, des icônes d'émotion ou des « émoticônes », des images graphiques, des entrées vocales et d'autres types de contenu multimédia) entrecoupées le texte des documents ou des messages. «

La demande de brevet est:

Récupération d'Images Graphiques Basée Sur L'état Émotionnel De L'utilisateur D'un Périphérique Informatique

Inventeurs: Matthias Grundmann, Karthik Raveendran et Daniel Castro Chin

Demande de brevet US: 20190228031

Publié: 25 juillet 2019

Date de dépôt: 28 janvier 2019Abstrait

L'invention concerne un dispositif informatique comprenant une caméra configurée pour capturer une image d'un utilisateur du dispositif informatique, une mémoire configurée pour stocker l'image de l'utilisateur, au moins un processeur et au moins un module. Le ou les modules peuvent être utilisés par le ou les processeurs pour obtenir, à partir de la mémoire, une indication de l'image de l'utilisateur du dispositif informatique, déterminer, sur la base de l'image, une première étiquette de classification des émotions, et identifier, sur la première étiquette de classification des émotions, au moins une image graphique provenant d'une base de données d'images préclassifiées ayant une classification émotionnelle qui est associée à la première étiquette de classification des émotions. Le ou les modules peuvent en outre être actionnés par au moins un processeur pour émettre en sortie au moins une image graphique.

Récupération d’image basée sur l’état émotionnel d’une personne

J'ai remarqué récemment dans une publicité Apple que quelqu'un se prélassait dans un environnement tropical lorsque son iPhone sonnait. Ils se détendent pour regarder le téléphone, qui capture leur visage et affiche des avis relatifs à l'appel téléphonique et des avis précédents.

C'est le Identité faciale fonctionnalité que les iPhones ou les iPad Pro viennent maintenant avec. On dirait que le Google Pixel 4 peut venir avec un Identité faciale fonctionnalité ainsi.

Ce brevet n’est pas mentionné dans ce brevet sur la récupération d’images en fonction de l’état émotionnel de l’utilisateur.

Mais cela ressemble à quelque chose qui pourrait mettre les gens à l'aise avec la caméra de leur smartphone et les utiliser pour faire quelque chose avec cette photo.

Avec Face ID, ce serait pour rendre le téléphone plus sécurisé.

L’approche biométrique, que j’ai écrite il ya trois ans environ, pourrait jouer un rôle dans le classement des résultats de recherche.

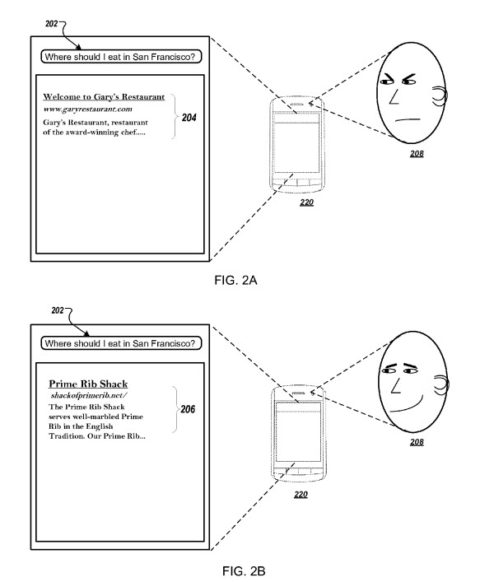

Le brevet biométrique nous indiquait qu’il pourrait potentiellement changer le classement des résultats en fonction des réactions des chercheurs aux résultats de recherche qu’ils voyaient.

Ce brevet sur le retour d’images graphiques basées sur des états émotionnels semble être un bon moyen de tester les émotions des gens et de rendre possible une telle approche biométrique.

Un extrait du brevet biométrique que j'ai déjà cité nous indique qu'il existe des facteurs spécifiques susceptibles de provoquer une augmentation ou une réduction du classement en fonction des résultats de la recherche:

«Les actions consistent notamment à fournir un résultat de recherche à un utilisateur; recevoir un ou plusieurs paramètres biométriques de l'utilisateur et une valeur de satisfaction; et former un modèle de classement en utilisant les paramètres biométriques et la valeur de satisfaction. Déterminer qu'un ou plusieurs paramètres biométriques indiquent un engagement potentiellement négatif de l'utilisateur avec le premier résultat de recherche comprend la détection:

- Augmentation de la température corporelle

- Dilatation de la pupille

- Les yeux se contractent

- Rinçage du visage

- Diminution du taux de clignotement

- Rythme cardiaque augmenté. »

Cette nouvelle demande de brevet fournit plus de détails sur la compréhension de l'émotion d'un utilisateur d'appareil photo de smartphone:

«L’appareil informatique peut analyser les traits du visage et d’autres caractéristiques de la photo susceptibles de changer en fonction de l’état émotionnel de la personne afin de déterminer une ou plusieurs étiquettes de classification des émotions. Les exemples d'étiquettes de classification des émotions incluent, par exemple, la forme de l'œil, la taille de l'ouverture de la bouche, la forme de la narine, la position des sourcils et d'autres caractéristiques et attributs faciaux susceptibles de changer en fonction de l'émotion humaine. Le dispositif informatique peut ensuite identifier une ou plusieurs images graphiques avec une classification émotionnelle (également appelée « émotion humaine » dans le présent document) qui est associée à la ou aux étiquettes de classification d'émotions. Les exemples de classifications émotionnelles incluent la colère, la peur, l'anxiété, le bonheur, la tristesse et d'autres états émotionnels. En utilisant une classification émotionnelle pour une image, le dispositif informatique peut trouver une image graphique avec un contenu émotionnel similaire à l'image capturée par la caméra. «

En plus de nous parler de la gamme d'émotions pouvant être classées, ce brevet fournit plus de détails sur la classification elle-même, comme s'ils essayaient de comprendre la meilleure façon de capturer de telles informations:

« Par exemple, le dispositif informatique peut déterminer qu'une image capturée comprend certains éléments faciaux qui définissent les étiquettes de classification des émotions de premier ordre, tels que les yeux grands ouverts et les narines évasées, et peut associer les étiquettes de classification des émotions de premier ordre à une classification telle que choc ou peur. Sur la base de la classification émotionnelle de second ordre, le dispositif informatique peut identifier une ou plusieurs images graphiques pouvant également représenter l'émotion susceptible d'être exprimée par l'utilisateur dans l'image capturée. Par exemple, le dispositif informatique peut récupérer une image graphique d'un acteur célèbre ou d'une actrice qui a été classée comme ayant une expression faciale choquée ou effrayante. «

Ce processus consistant à renvoyer une image en réponse aux photos de l'utilisateur de smartphones permettrait aux utilisateurs de sélectionner des aspects de l'image graphique renvoyée – ce qui leur permettrait de contribuer à la formation de l'identification des émotions dans les images qu'ils soumettent au cours de ce processus. .

À emporter

Lorsque j’ai écrit pour la première fois sur le processus de classement biométrique des brevets à l’aide d’un appareil photo pour smartphone, il ya trois ans, je ne m'attendais pas à ce que quiconque soit à l’aise que Google utilise la réaction d’une personne aux résultats de recherche pour influencer le classement de ces résultats.

J’ai également mis en doute la capacité de Google à reconnaître les émotions derrière la réaction d’un internaute aux résultats de recherche. Je me demande toujours si le moteur de recherche pourrait offrir un tel confort.

Ensuite, j'ai commencé à voir des vidéos d'Apple sur l'utilisation d'un appareil photo de smartphone avec un identifiant de visage pour déverrouiller ce téléphone. Et il semble que Google pourrait ajouter une telle capacité à Pixel Phones.

Est-ce que cela amènerait les gens à se sentir un peu plus à l'aise lorsqu'une caméra smartphone lira leur visage et essaiera de comprendre leurs émotions pendant leur recherche afin de classer éventuellement les résultats de recherche?

Ce brevet tenterait de comprendre les émotions sur les visages et de restituer des images graphiques reflétant ces émotions en réponse. Est-ce quelque chose que les gens utiliseraient et se sentiraient à l'aise?

Internet nous a présenté de nouvelles façons d’interagir avec le monde – transformant nombre d’entre nous en auteurs qui publient quotidiennement des articles sur des blogs et des réseaux sociaux.

Nous soumettons des photos de notre vie quotidienne sur ces blogs, réseaux sociaux et services tels qu'Instagram.

Les gens enregistrent chaque jour des vidéos d'eux-mêmes sur des sites tels que YouTube.

Accepterons-nous que Google utilise nos réactions émotionnelles lors de la recherche des résultats de la caméra de notre smartphone pour influencer le classement des pages Web?

Plus de ressources:

Crédits d'image

Capture d'écran prise par l'auteur, juillet 2019